本报讯 (记者梁傲男)7月28日,北京智谱华章科技股份有限公司(以下简称“智谱”)发布新一代旗舰模型GLM-4.5,专为智能体应用打造的基础模型。Hugging Face与ModelScope平台同步开源,模型权重遵循MIT License。

据悉,GLM-4.5在包含推理、代码、智能体的综合能力达到开源SOTA,在真实代码智能体的人工对比评测中,实测国内最佳。

智谱方面有关人士表示,衡量AGI的第一性原理,是在不损失原有能力的前提下融合更多通用智能能力,GLM-4.5是智谱对此理念的首次完整呈现,并有幸取得技术突破。GLM-4.5首次在单个模型中实现将推理、编码和智能体能力原生融合,以满足智能体应用的复杂需求。

智谱/供图

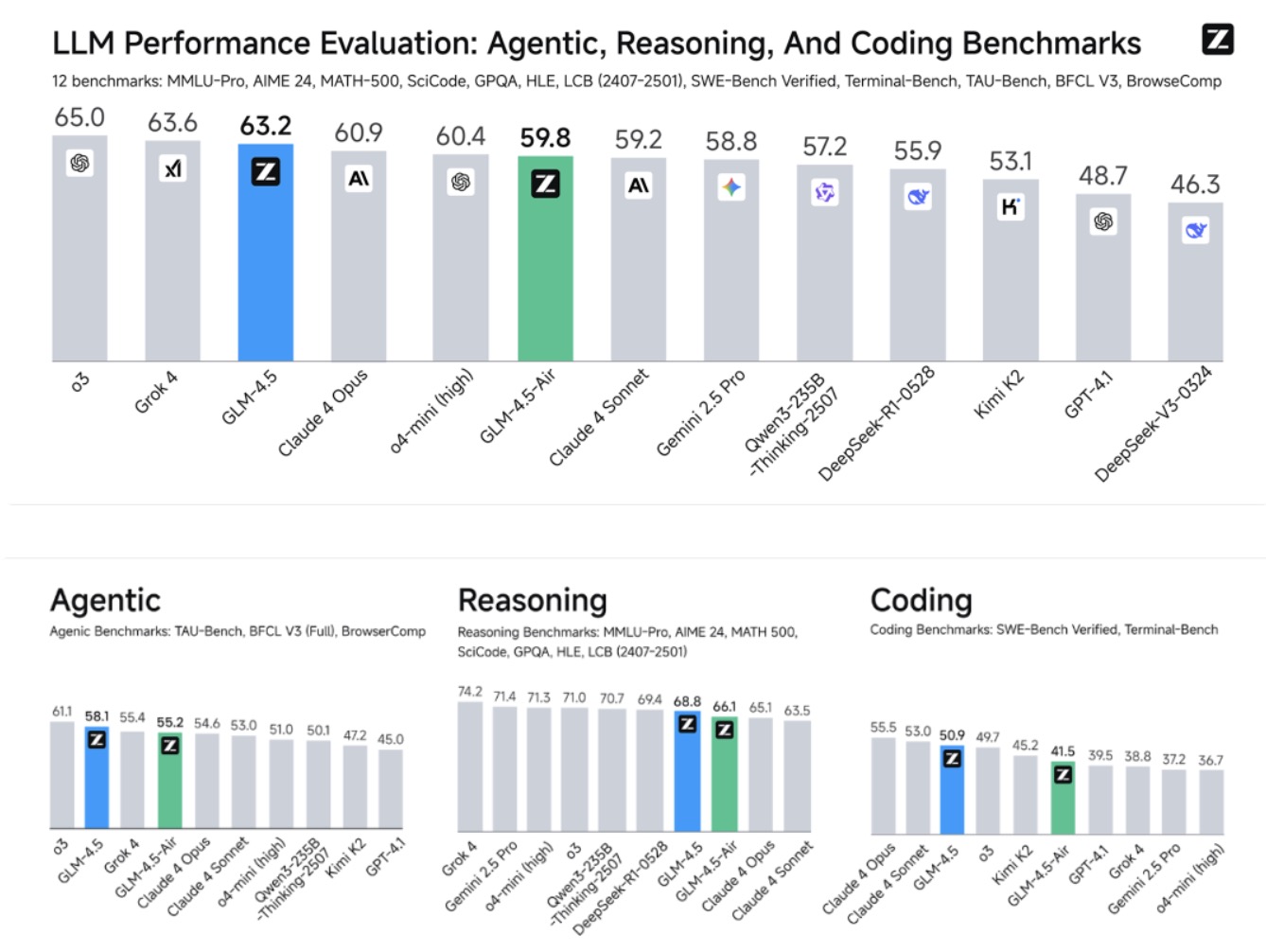

记者了解到,为综合衡量模型的通用能力,智谱选择了最具有代表性的12个评测基准,综合平均分,GLM-4.5取得了全球模型第三、国产模型第一,开源模型第一。

在参数效率方面,GLM-4.5参数量为DeepSeek-R1的1/2、Kimi-K2的1/3,但在多项标准基准测试中表现得更为出色,这得益于GLM模型的更高参数效率。在衡量模型代码能力的SWE-benchVerified榜单上,GLM-4.5系列位于性能/参数比帕累托前沿,表明在相同规模GLM-4.5系列实现了最佳性能。

在性能优化之外,GLM-4.5系列也在成本和效率上实现突破,由此带来远低于主流模型定价:API调用价格低至输入0.8元/百万tokens,输出2元/百万tokens。同时,高速版本实测生成速度最高可至100 tokens/秒,支持低延迟、高并发的实际部署需求,兼顾成本效益与交互体验。

真实场景表现比榜单更重要。为评测GLM-4.5在真实场景Agent Coding中的效果,智谱接入Claude Code与Claude-4-Sonnet、Kimi-K2、Qwen3-Coder进行对比测试。测试采用52个编程开发任务,涵盖六大开发领域,在独立容器环境中进行多轮交互测试。实测结果显示(如下图),GLM-4.5相对其他开源模型展现出竞争优势,特别在工具调用可靠性和任务完成度方面表现突出。尽管GLM-4.5相比Claude-4-Sonnet仍有提升空间,在大部分场景中可以实现平替的效果。

(编辑 张明富)

京公网安备 11010602201377号京ICP备19002521号

京公网安备 11010602201377号京ICP备19002521号